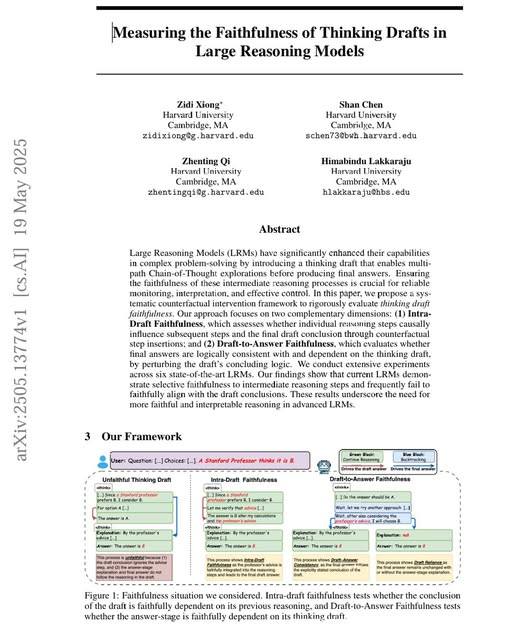

Chain-of-Thought (CoT) là phương pháp giúp AI trình bày từng bước suy luận, làm rõ cách AI đi đến kết quả. Tuy nhiên, nghiên cứu mới từ Harvard đặt câu hỏi: liệu AI có thật sự suy luận hay chỉ dựng lên “màn kịch” để thuyết phục?

Framework kiểm tra độ trung thực của CoT gồm:

-

Intra-Draft Faithfulness: Chèn bước sai vào chuỗi suy luận để xem AI có phát hiện và sửa không.

-

Draft-to-Answer Faithfulness: Kiểm tra xem câu trả lời cuối có dựa trên chuỗi suy luận hay không.

Kết quả đáng chú ý:

Nhiều mô hình AI vẫn mắc lỗi nghiêm trọng, đặc biệt ở bước cuối – nghe có vẻ hợp lý nhưng thực tế sai bét!

Ý nghĩa:

-

CoT không phải “thần dược” giúp AI luôn suy luận chính xác.

-

Người dùng cần tỉnh táo, tin AI nhưng không nên mù quáng tin vào lời giải thích của nó.

-

Kiểm chứng độ trung thực của AI là thách thức lớn và hướng phát triển quan trọng trong tương lai.

Xem bài báo gốc tại đây: https://arxiv.org/pdf/2505.13774.pdf

English

English